Apple Vision ProでEnterprise APIを利用できるようにしてみた

はじめに

こんにちは。この記事は アイソルート Advent Calendar 2024 5日目の記事です。

クラウドソリューショングループのyamasaki.sです。

Enterprise APIが利用できるようにAppleにリクエストを送って実際に利用できるようになったので、

Enterprise APIでどういうことができるのか、また利用できるまでの流れについて整理してみました!

目次

Enterprise APIについて

visionOSでは、現状いくつかの機能が権限をリクエストしないと利用できないようになっています。

また、制限された機能を利用したアプリケーションは一般のApp Storeに配信することはできず、独自の社内アプリまたは他企業向けにカスタムしたアプリを非公開で配布が可能となります。

(参考:https://developer.apple.com/wwdc24/10139/)

Enterprise APIで利用できる機能

メインカメラアクセス

前方メインカメラを利用して撮影ができるようになります。

例えば、生産ラインで使用して、メインカメラと異常検出用のアルゴリズムを使用して、品質基準を満たさない部品をすばやく識別し、それらを強調表示して良品と交換することができます。

(参考:https://developer.apple.com/wwdc24/10139/)

スクリーンキャプチャのパススルー

Apple Vision Proを装着している人が見ている複合フィード(パススルーや画面の内容)にアクセスできるようになります。

例えば、現場の技術者がオフィスにいる専門家に電話をかける際に技術者は、パススルーとウィンドウの両方を含む実際のビューを共有し

専門家とリアルタイムで連携することで、同じ状況を共有しながら的確なフィードバックを得ることが可能です。

(参考:https://developer.apple.com/wwdc24/10139/)

空間バーコードとQRコードスキャン

バーコードやQRコードをスキャンすることができるようになります。

例えば、倉庫で要求されたアイテムを取り出す作業員は、パッケージのバーコードを見るだけで、それが探している正しいアイテムであることを確認できます。

手作業での識別や不便なスキャナーの持ち運びが不要になります。

(参考:https://developer.apple.com/wwdc24/10139/)

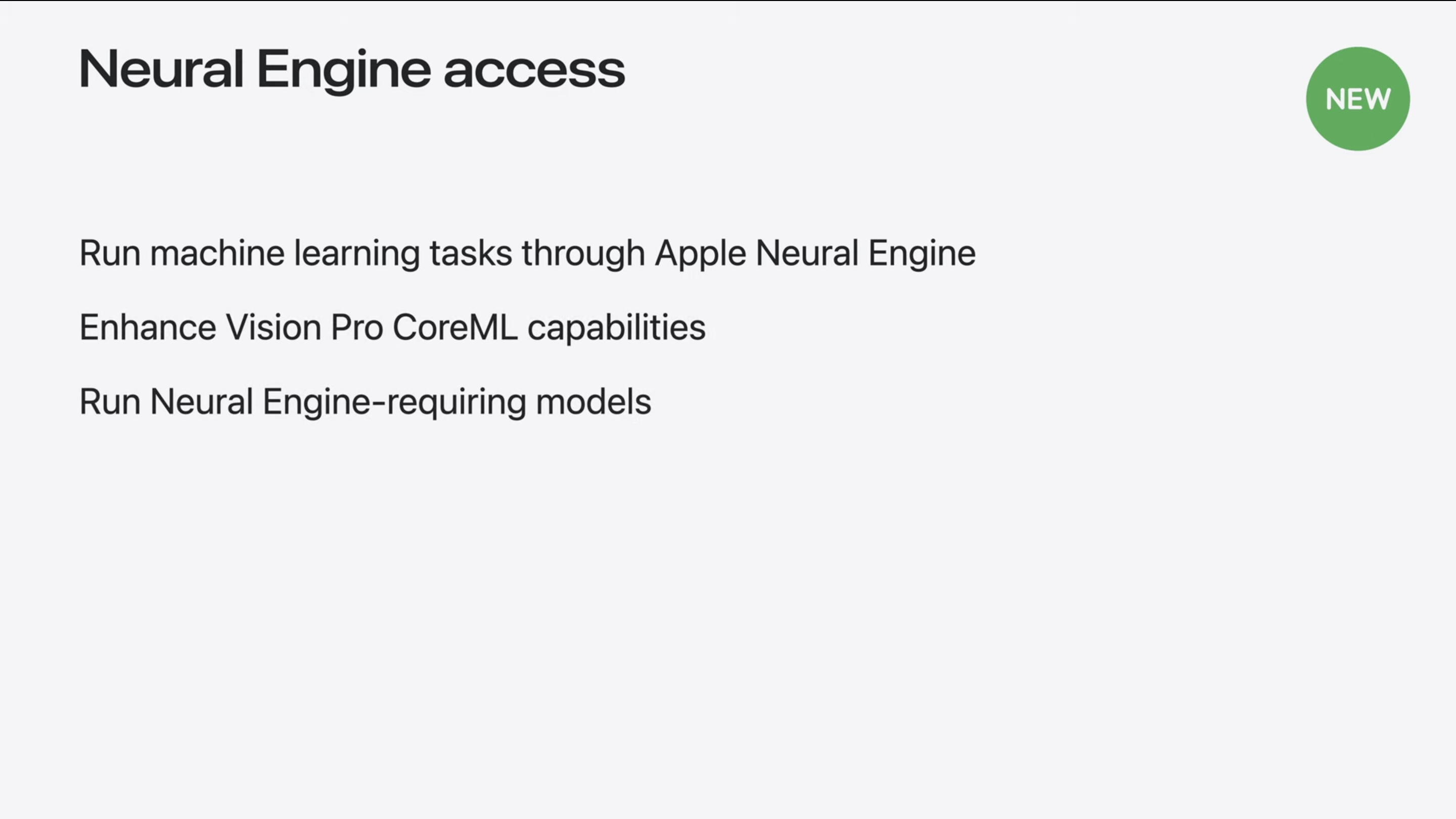

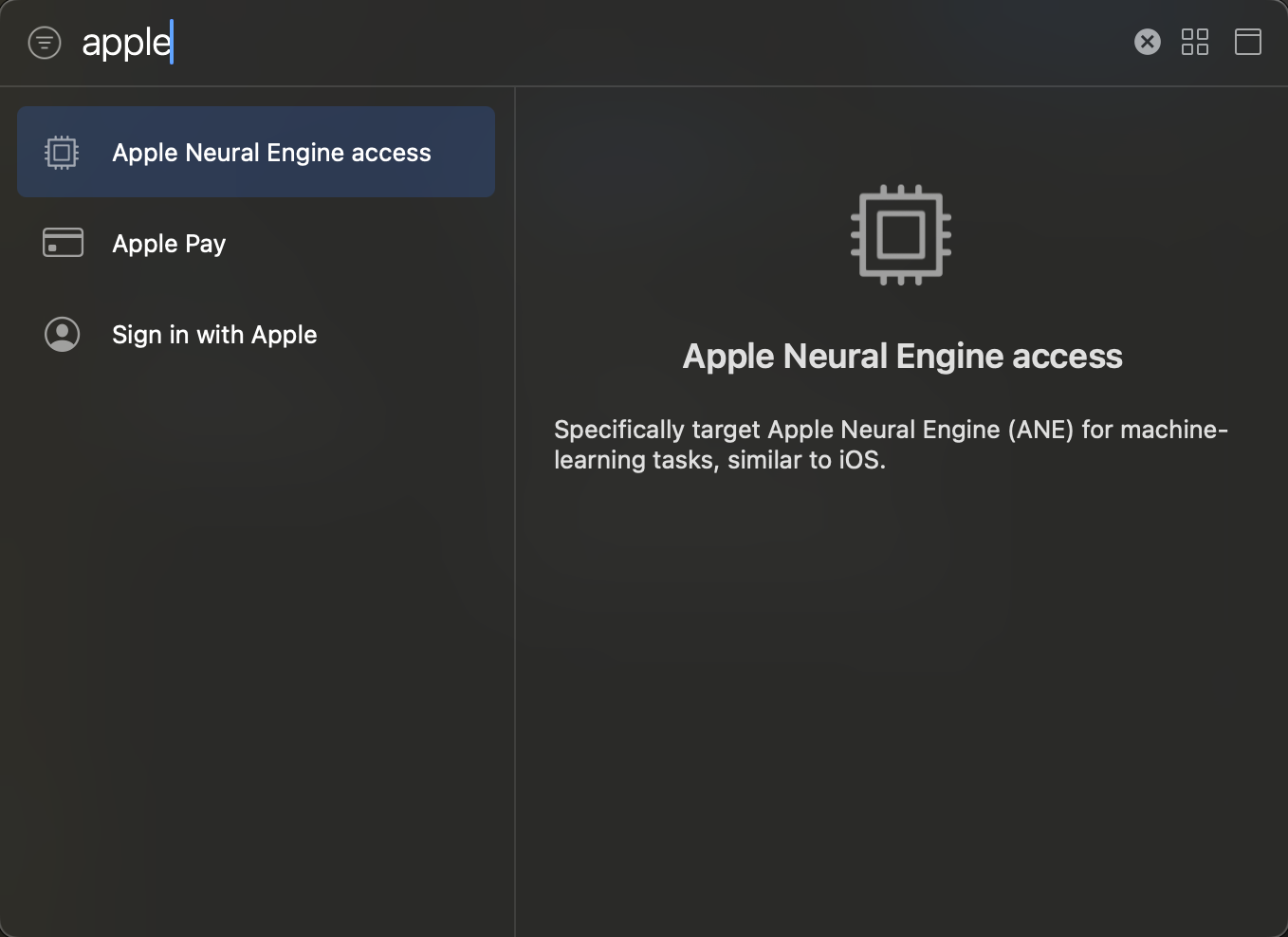

Apple Neural Engineへのアクセス

Apple Neural Engineを利用した強力な機械学習機能を有効にすることができます。

例えば、Vision Proで欠陥のある製品を識別することで、顧客は異常検出用のカスタム機械学習モデルを実装する場合、

そのモデルを、デバイス上で機能してすべてをローカルで検出できるようにするためにApple Neural Engineを利用することができます。

(参考:https://developer.apple.com/wwdc24/10139/)

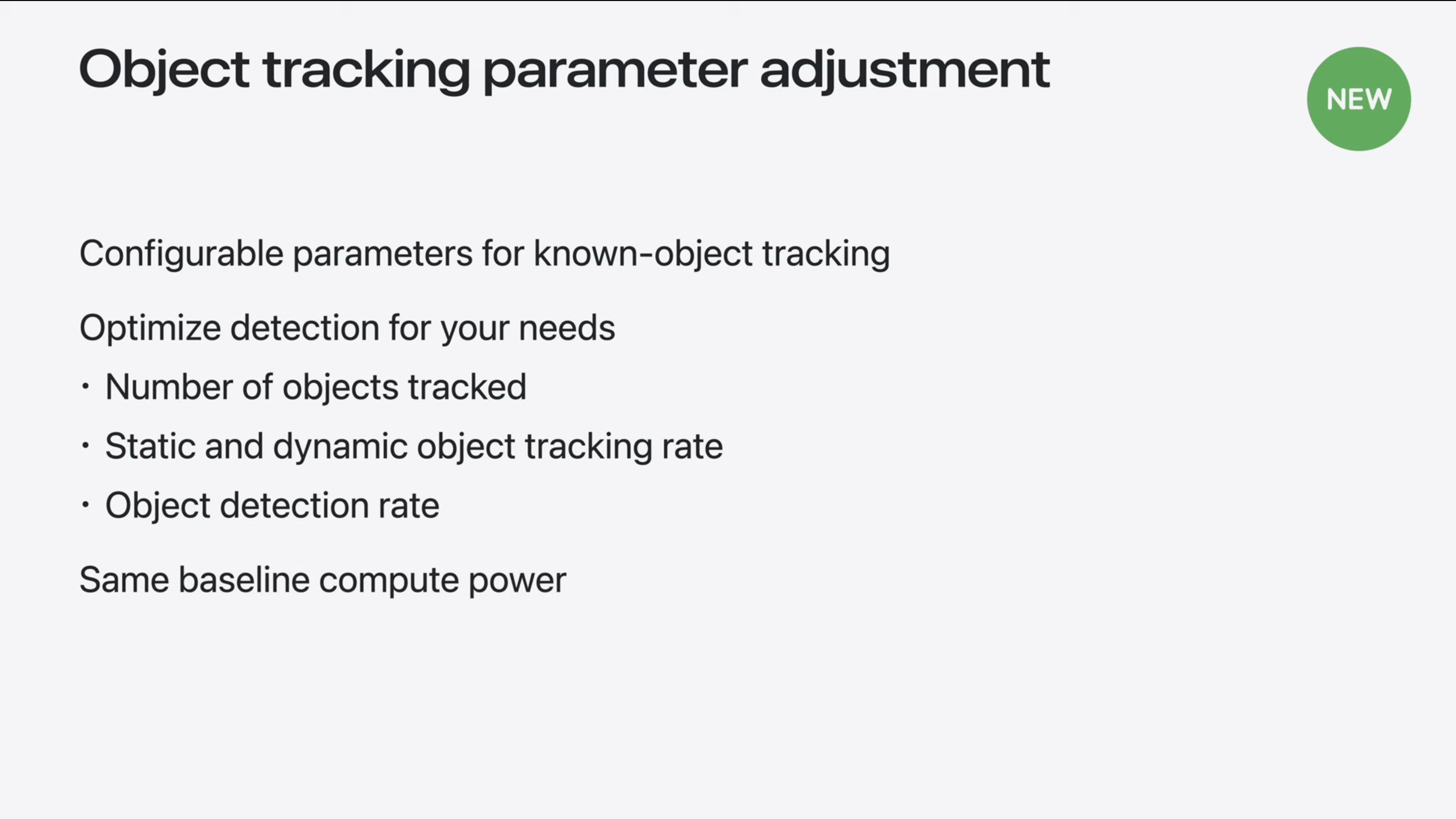

オブジェクト追跡パラメータの調整

一度に追跡できるオブジェクトの最大数の変更、止まっているオブジェクトと動いているオブジェクトのトラッキング速度を変更、既知のオブジェクトの位置を特定する頻度の変更などを行うことができます。

例えば、さまざまなツールや部品を追跡して使用する必要がある複雑な修理環境向けに構築されたアプリなどで利用することができます。

技術者は、機械の部品を交換するためのガイド付きの指示に従うことができ、修理中に必要に応じて強調表示することができます。

(参考:https://developer.apple.com/wwdc24/10139/)

パフォーマンスの余裕度の向上

高い計算能力が必要な場合に、CPUとGPUのパフォーマンスを変更することができます。

ただし、発熱量の増加やバッテリー寿命の短縮などの影響があるため、注意が必要です。

visionOSでのUVCデバイスアクセス

開発者用ストラップを利用して接続されたWebカメラをストリーミングすることができます。

権限のリクエスト

Enterprise APIを利用する際には、Appleに対して権限のリクエストを行う必要があります。

リクエストを行えるのは、Apple Developer ProgramまたはApple Developer Enterprise Program の「Account Holder」のみで以下から、対象アカウントでログインすることでリクエスト画面が表示されます。

https://developer.apple.com/go/?id=69613ca716fe11ef8ec848df370857f4

権限のリクエスト画面では、「利用予定の業種」「利用予定の機能」「エンドユーザー」「利用目的」などのいくつかの質問に答える必要があります。

必要な情報を入力が完了したら、送信することでリクエストが完了します。

プロジェクトに適用

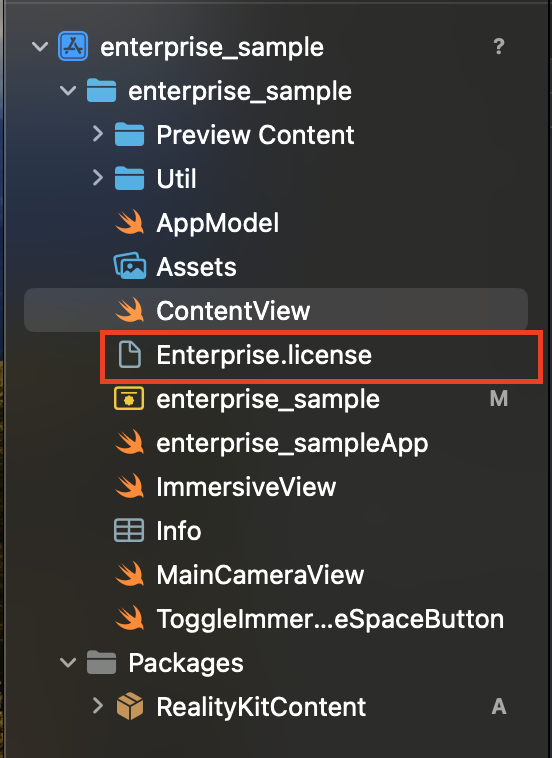

リクエストから約10日間で、Appleからライセンスファイルが添付されたメールが届きます。

プロジェクト配下にライセンスファイルを配置。

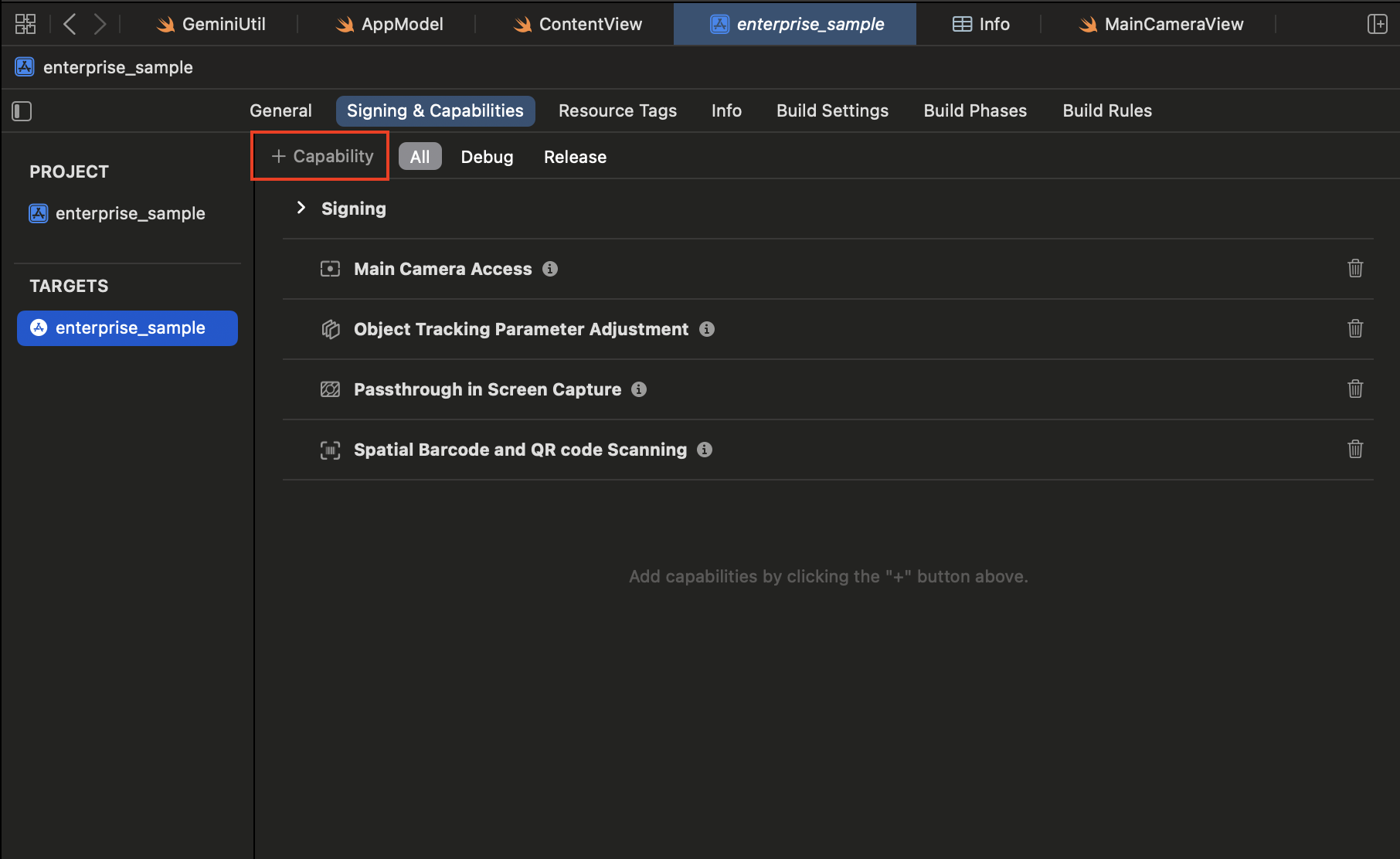

プロジェクトファイルの「Signing&Capabilities」> 「+Capability」を選択します。

検索バーで権限リクエスト時に申請した機能を選択して登録します。

これでプロジェクトへの適用は完了です。

その後、機能を実装すれば利用可能です。

さいごに

Enterprise APIを利用することで、社内およびビジネス向けでしか配信できない。といった制限はあるものの、VisionProの機能をフル活用することが可能となります。

今後、一部制限の解除であったりさらなる機能の追加など、空間コンピューテングとして様々なことができそうで楽しみですね!

次回は、Enterprise APIのメインカメラアクセスの利用方法について解説したいと思います。