OllamaでローカルAIモデルの試用

目次

こんにちは。

クラウドソリューショングループ2のkongsです。

ChatGPTのようなLLMの登場により、こうしたAIモデルを職場で活用したいというニーズが高まっています。

一方で、データ収集の懸念や企業の機密情報漏洩といったリスクが、ビジネス環境での導入を阻む要因となっています。

さらに、AIモデルを運用するためには通常、高性能なGPUを要することもあり、導入のハードルは依然として高いのが現状です。

本日は、AIモデルをローカル環境でホストできる「Ollama」というプログラムをご紹介します。

一部のモデルでは、高性能なハードウェアがなくても動作可能であるため、比較的手軽に試すことができます。

なぜOllamaの使用

Ollamaは、AIモデルをローカル環境で試すことを可能にします(必要なリソースがあることが前提です)。

これにより、新しいAIモデルがどの程度機能するのか、またどのような特徴があるのかを確認することができます。

たとえば、

ネットワークに詳しい方であれば、自分自身でChatGPTのようなサービスをホストし、他の人に使ってもらうことも可能です。

(主に、AIを活用した新しいSaaS製品のアイデアを、本格的に取り組む前に簡単に検証する手段として存在しています。)

Ollamaのセットアップ方法

https://ollama.com/

上記のリンクにアクセスすることで、現在のOS環境に適したOllamaのバージョンをダウンロードできます。

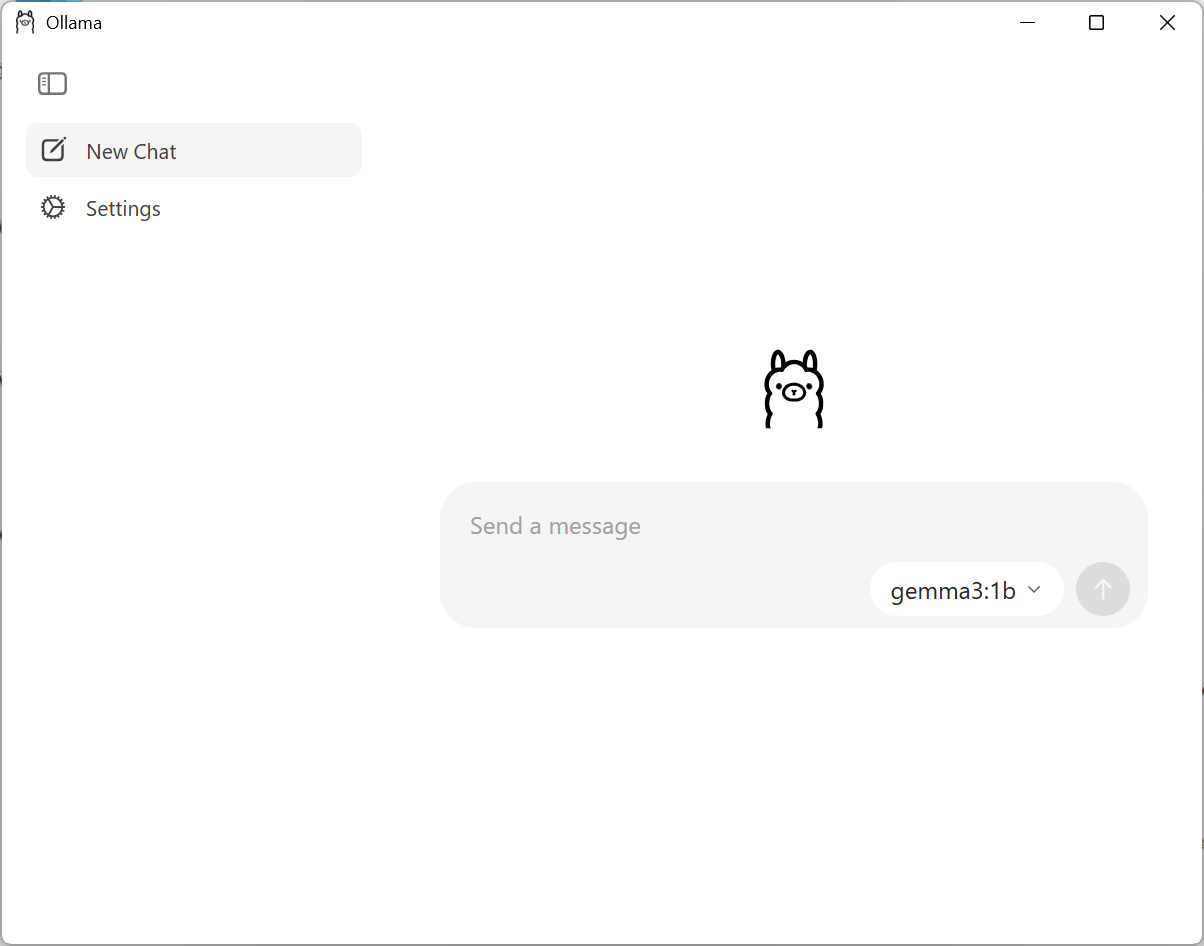

最新のアップデートにより、Ollamaは使いやすいUIも提供されるようになりました。

本日は、Ollamaを使って「llama3.2-vision」モデルを試してみます。(試したいモデルは個別にダウンロードする必要がありますので、その点にもご注意ください。)

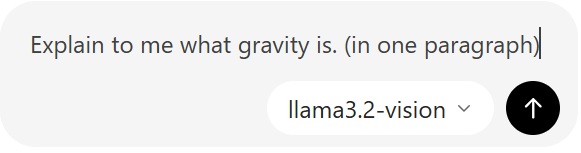

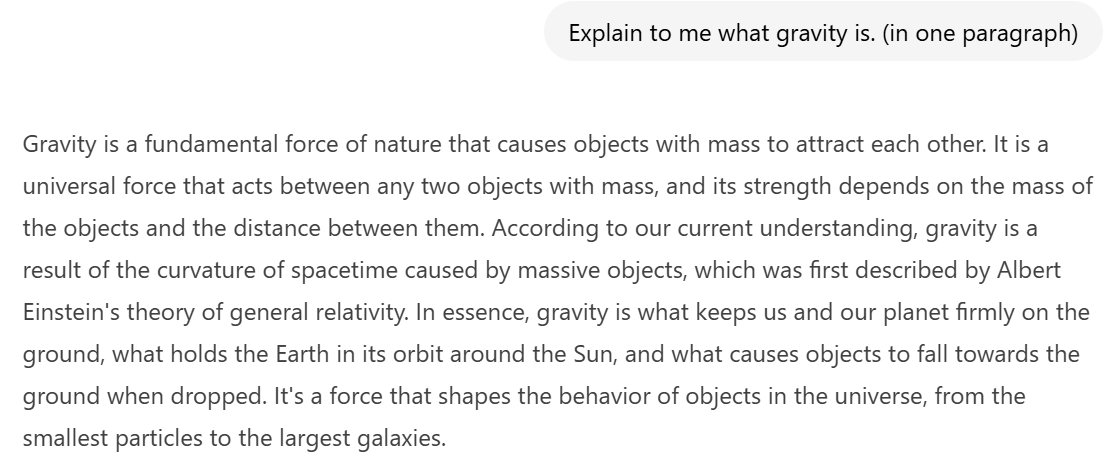

先ずは正確性とテキストでの回答能力を試すために、“重力とは何か説明してください”という質問を聞きました。(念のため、英語で質問してみました。)

返した内容は正確性が高いと感じました。また、返した内容の量もかなり多いと感じました。(1段落にまとめる条件を追加しました。)

返した内容は正確性が高いと感じました。また、返した内容の量もかなり多いと感じました。(1段落にまとめる条件を追加しました。)

次は、日本語能力を試すために、先回答した内容を日本語で言い返すことをお願いしました。

先の内容を日本語に翻訳することができています。

最後に、一つの笑っているペンギンの画像を共有し、見えるかどうかを試しました。

画像ファイルをドラッグ&ドロップで入力することができます。

(「llama3.2-vision」というモデルは画像認識機能が付いています。)

以上の返事をもらうためかなり長い時間を待ちました。(10分超えました)

また、日本語の記述にはミスがかなり多く入っていて、画像モデルの機能はもう少し精度が望ましいと感じました。

プライバシーとセキュリティについて

AIサービスを提供しているプロバイダーは自分のモデルをさらに改善していくため、ユーザーが利用したプロムプトや会話情報を収集しています。

こういった理由から、業務内でのChatGPTなどの生成AIサービスの利用を禁止している企業も多くあります。

(業務内の機密情報は載せないでください。)

ところが、Ollamaを通してAIモデルを利用することであれば、この問題点がなくなります。

https://github.com/ollama/ollama

そして、Ollamaはオープンソースのソフトウェアとなるため、中身のコードは公開されているため、ユーザー情報を収集しないポイントが確かめられます。

(このポリシーが将来変更される場合は、Ollama を使用しているさまざまな開発者とサービスから通知されます。)

結論

Ollamaを使うことにより、ローカル環境でAIモデルを試すことが便利となります。 これにより、AI モデルをホストするためのサーバーが必要になる問題や、外部の AI ウェブサイトの使用に関連する問題が解決されます。興味がある方はぜひ試してみてください。